„Der Fotojournalismus braucht eigentlich gar keine KI“

Der Berliner Fotokünstler Boris Eldagsen ist einer der profiliertesten Experten im Bereich Künstliche Intelligenz (KI) und Fotografie. Im April hat er ein weltweites Medienecho ausgelöst, als er die Annahme des SONY World Photography Award auf offener Bühne verweigerte. Eldagsen hatte ein KI-generiertes Bild eingereicht und – ein absolutes Novum – damit den renommierten Wettbewerb gewonnen. Dabei wollte er mit seiner Teilnahme eigentlich eine öffentliche Diskussion über das Verhältnis von KI und Fotografie anstoßen. Im Fachjournalist-Interview spricht er über die Aktion und den Einfluss von Künstlicher Intelligenz auf den Fotojournalismus.

Herr Eldagsen, im April waren sie weltweit in den großen Nachrichtenmedien präsent, weil Sie die Annahme des SONY World Photography Award auf offener Bühne verweigert haben. Was ist da passiert?

Ich hatte den SONY World Photography Award mit „The Electrician“ gewonnen, in der Kategorie „Open Creative“.

Die Wettbewerbsteilnahme beim SONY World Photography Award mit diesem KI-generierten Bild war ein von mir geplanter Stresstest. Ich wollte sehen, ob man sich mit KI-Bildern bei großen Fotowettbewerben bewerben und wie weit man damit kommen kann.

Wusste SONY, dass das Bild von einer KI generiert war?

Ich hatte SONY deutlich darauf hingewiesen, dass das Bild mit einer KI generiert wurde und die Preisvergabe unter Umständen Kontroversen auslösen würde. Mein Ziel war, eine öffentliche Diskussion darüber anzustoßen, welchen Stellenwert KI in der Fotografie hat. Dazu hatte ich dem Komitee auch meine Referenzen, die Website und den Insta-Account zur Kenntnis gegeben. Daraus wird ersichtlich, dass ich mit KI arbeite.

Wie ist SONY mit dieser Information umgegangen?

Eine Diskussion fand leider nicht statt. Dreimal ist die Agentur des SONY Awards nicht auf meine Gesprächsangebote eingegangen. Sie haben den KI-Zusammenhang einfach nicht kommuniziert.

Deshalb habe ich am 13.4. auf der Preisverleihung den Preis öffentlich abgelehnt. Niemand der Organisatoren suchte danach das Gespräch mit mir. Am nächsten Morgen war ich von der Webpage getilgt und aus der Ausstellung im Somerset House verschwunden.

Warum halten Sie die Diskussion über einen KI-Einsatz bei der Fotografie – konzentrieren wir uns hier auf den Fotojournalismus und sagen „bei der journalistischen Fotografie“ – für wichtig?

Wenn man über positive und negative Szenarien des KI-Einsatzes beim Fotojournalismus redet, muss man zunächst einmal sagen: Der Fotojournalismus, die dokumentarische Fotografie, braucht eigentlich gar keine KI. Um etwas abzubilden, was man vor der Linse hat, sollte man auch keine KI benutzen, denn es geht hier um Authentizität.

Dabei bin ich als Bürger eines freien Landes am Funktionieren der Demokratie, die ich sehr schätze, und an ihren Säulen – darunter die freie Presse – interessiert. Dazu gehört auch der Fotojournalismus. Denn er hilft dabei, überhaupt erst einmal eine objektive Faktenlage herzustellen, über die man dann diskutieren kann.

Boris Eldagsen und sein KI-generiertes Werk PSEUDOMNESIA | THE ELECTRICIAN, für das er den SONY World Photography in der Kategorie „Creative / Open Competition“ erhalten, aber abgelehnt hat. Foto: Alex Schwander.

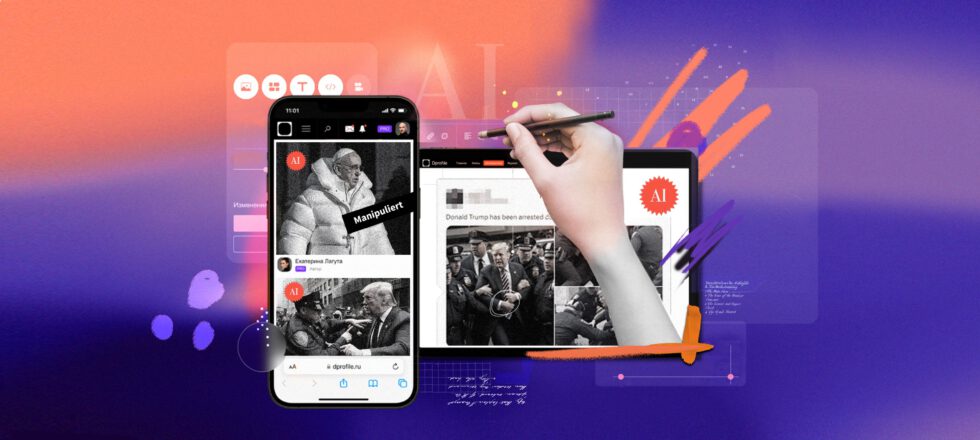

Alle werden jetzt spontan an die KI-generierten Fakebilder von Trumps Verhaftung, Putins Kniefall vor Xi oder den Papst im Balenciaga-Mantel denken. Wie kommen solche Bilder zustande?

Seit dem Sommer produziere ich selbst alle zwei Monate „Fake Documentary“-Bilder, um zu zeigen, wie schnell sich deren Qualität verbessert. Mit dem Release des Programms Midjourney 5 ist die Technologie inzwischen so weit, dass man den Fake fast nicht mehr sieht. Man kann Prominente einbauen und mit ganz einfachen Mitteln Bilder erzeugen – Bilder, die etwa für meine Mutter durchaus glaubhaft sind.

Ein Bild wie das des Papstes im Balenciaga-Mantel ist eigentlich sehr schnell gemacht, über eine Funktion namens Blend. Dazu muss man nur zwei Bilder hochladen, die dann vom System „zusammengebacken“ werden. Man braucht kaum Vorwissen, um solche Bilder herzustellen. Die Anweisung „Trump gets arrested“ als Prompt, also als textliche Aufforderung an die KI formuliert, genügt eigentlich schon. Bildmaterial ist ja bereits in der Datenbank.

Bei Gesichtern, Oberkörpern oder Haut sind die Programme bereits sehr gut. Bei Händen oder Füßen haben sie noch Schwächen. Fotografisch gesehen gibt es oft noch eine Unlogik bei der Mischung von Schärfe und Unschärfe einzelner Details. Bis Ende des Jahres werden diese Probleme aber auch gelöst sein.

Welche Wirkungen haben solche Fakes? Besonders dann, wenn sie schnell und unkommentiert über die Medien verbreitet werden?

Faktisch haben diese Bilder, selbst wenn sie als Satire geplant waren, den fatalen Effekt, dass sie das Misstrauen und die Abwendung des Publikums von den traditionellen Medien noch beschleunigen. Propaganda hat dann ihr Ziel erreicht.

In der britischen Presse gab es übrigens durchaus Versuche, diese Bilder, klar gekennzeichnet als Fakes, zu Informations- und Bildungszwecken einzusetzen. An ihnen wurde erklärt, wie sie zustande kommen und wofür sie genutzt werden können. Die BILD dagegen hat die Bilder lediglich als spektakuläre Treppenwitze präsentiert, ganz ohne Einordnung.

Wird KI bereits jetzt in den Medienhäusern eingesetzt, um Fotos zu erzeugen?

Für die Deutsche Fotografische Akademie, die DFA, moderiere ich den Digitalen Dialog. Dabei unterhalten wir uns mit Menschen aus der Fotoszene auf ZOOM und auf Instagram auch über digitale Entwicklungen.

Letztes Jahr haben wir mit dem Bildredakteur der F.A.Z. über den Wahrheitsgehalt von Symbolbildern gesprochen. Dabei wurde deutlich, dass die F.A.Z. keinen Wert auf den authentischen thematischen Zusammenhang von Symbolbildern legt. Ein Beitrag über Altersvorsorge wird beispielsweise mit zwei Rentnern auf einer Bank illustriert. Dass die aber ursprünglich im Zusammenhang zu einem Beitrag über Enkel fotografiert wurden, spielt keine Rolle. Das Bild musste lediglich dokumentarisch erstellt worden sein.

Deshalb denke ich, dass Verlage Symbolbilder bald auch über KI produzieren werden – das spart einfach Geld. Das gilt auch für Grafiken.

Mit welchen KI-Programmen sollten sich Fotojournalist:innen jetzt auseinandersetzen?

In meinem ZOOM-Vortrag für den Fotograf:innen-Verband Freelens habe ich die wichtigsten Arbeitsweisen und Programme für eine KI-generierte Bildproduktion vorgestellt. Die wichtigsten Programme zurzeit sind Midjourney, Stable Diffusion und DALL-E 2. Adobe Firefly arbeitet mit Stockmaterial, ist aber noch nicht komplett freigeschaltet.

Man kann bei den Arbeitsanweisungen übrigens grundsätzlich mit textbasierten oder mit bildbasierten Prompts arbeiten, aber auch beides miteinander kombinieren.

Welche Vorkenntnisse verlangen die Programme?

Die genannten Plattformen verlangen verschiedene Vorkenntnisse. Nur für DALL-E 2 sind keine Vorkenntnisse nötig. Die Plattform ist sehr einfach und benutzerfreundlich.

Stable Diffussion als Open-Source-Modell ist wahnsinnig komplex und kompliziert. Deshalb existieren dafür mittlerweile auch zahlreiche Zwischenhändler. Die haben aus den etwa 3.000 Modellen zehn herausgepickt, von denen sie glauben, dass das die von den Nutzer:innen am stärksten nachgefragten sind. Dann haben sie eine chice Website darüber gebaut und bieten an, damit für zehn US-Dollar monatlich etwa 1.000 Bilder zu generieren.

Midjourney ist die beste Schnittmenge all dieser Programme und generiert die besten Ergebnisse. Allerdings ist das Programm über den Gaming Server Discord zugänglich – das schreckt viele Menschen ab, die keine Gamer:innen sind.

Welche Kosten entstehen bei der Nutzung der Programme?

Bei der Nutzung der Open-Source-Lösungen entstehen keine Kosten. Man braucht einen einigermaßen leistungsfähigen Rechner oder kann die Programme alternativ über Google Open Co Lab nutzen. Dann lagert man die Rechenpower zu Google aus und ist mit etwa zehn US-Dollar im Monat dabei. Nutzt man die besagten Zwischenhändler, wird es teurer.

Bei Midjourney gibt es eine Staffelung im Preis. Wer schneller rechnen lassen möchte, zahlt mehr, wer Zeit hat, zahlt weniger. Bei Midjourney werden auch alle Prompts und Ergebnisse öffentlich gemacht. Und dürfen auch wieder von Dritten remixt werden. Wer das nicht möchte, kauft das Nutzungsmodell Stealth, die „Tarnkappe“, und zahlt dann etwa 40 bis 60 US-Dollar pro Monat.

Viele Fotograf:innen befürchten, dass ihre Bilder unautorisiert in die Trainingsdaten dieser KIs übernommen werden. An den so erzeugten Bildern haben sie dann keine Rechte und bekommen auch keine Honorare dafür. Was halten Sie von diesen Befürchtungen?

Ich verstehe, dass sich die Kolleg:innen sorgen, dass ihr Bildmaterial benutzt wird. Wenn ich aber einen praktischen Realismus vertrete, muss ich sagen: Wenn man seine Fotos, egal wo, öffentlich zeigt, ist es einfach nicht mehr nachzuvollziehen, ob eine Person A ein Bild von Person B benutzt. Schon ein Handyfoto eines fremden Bildes wandert in den Prozess.

Wenn ich eine eigene Handschrift entwickelt habe, die unverkennbar ist, dann ist es eigentlich egal, ob mein Ausgangsmaterial in den Trainingsdaten auftaucht oder nicht. Denn ChatGPT kann diese visuelle Sprache textlich beschreiben und als Vorlage für Textprompts nehmen. Den Prozess nennt man Unbundling. So kann ich selbst zum Beispiel mittlerweile, unter Einbeziehung von GPT, sehr gute Aufnahmen von Helgoland im Stil des berühmten Landschaftsfotografen Ansel Adams generieren.

Stable Diffusion legt übrigens seine Trainingsdaten offen und wird deshalb, im Unterschied zu Open AI und Microsoft, die daraus ein Geschäftsgeheimnis machen, auch dauernd verklagt.

Als sehr schlauen Schachzug hat Stable Diffusion Nutzer:innen auf der Plattform Have I been Trained bis zum 3. März die Möglichkeit eingeräumt, dort nach ihren eigenen, für Trainingszwecke verwendeten Bildern zu suchen und sich dann auszutragen, sodass die nicht mehr genutzt werden können. Viele Milionen Menschen, letztlich aber nur drei Prozent der Nutzer:innen, haben davon Gebrauch gemacht.

Derzeit entscheidet sich in verschiedenen Gerichtsverfahren, ob die Praxis des Grabbings, also der Nutzung fremder Bilder bei der Generierung von KI-Bildern, legal ist.

Welche Konsequenzen wird das für die wirtschaftliche Situation der Kolleg:innen haben?

Das wird ein großes Problem für Berufsfotograf:innen und damit auch für Fotojournalist:innen. Viele von ihnen können ja nicht vom Fotojournalismus alleine leben und müssen deshalb nebenher weitere fotografische Aufträge ausführen.

Der kommerzielle berufsfotografische Bereich mit Werbung, Produktfotografie, Symbolbildern wird sich verändern. Jobs fallen weg, Existenzen werden prekärer.

Kann ich eigentlich auf eigene KI-generierte Bilder ein Copyright anmelden?

Es gab vor einem Jahr ein inzwischen überholtes Gerichtsurteil in den USA, das sagt, dass man auf KI-generierte Bilder kein Copyright anmelden kann. Die Urheberschaft greife nicht, weil man den technischen Prozess nicht steuern könne und nur auf den Button Generate gedrückt habe.

Gerade erst hat die Comiczeichnerin Kris Kashtanova, die einen Comic unter KI-Einsatz kreiert hat, einen weiteren Rechtsstreit geführt. Sie hat einen Teilerfolg erzielt und geht jetzt in die Berufung gegen das Urteil.

Aber wie entsteht überhaupt eine Autor:innenschaft bei KI-generierten Bildern?

Bei den Open-Source-Programmen werden immer mehr manuelle Steuerungsmöglichkeiten eingebaut. So kann man die Lösungen immer besser auf die eigenen Anforderungen hin trainieren. Der Zufall bei der KI-Generierung von Bildern wird also immer weiter reduziert. Ein komplexer Workflow, eine Autorenschaft, die dann natürlich auch geschützt werden sollte, wird immer wichtiger.

Meine teilweise elfteiligen Prompts, quasi meine Coca-Cola-Rezepte, mache ich natürlich nicht öffentlich. Sie liegen auf meinem Rechner und ich gebe sie nicht her. Sie definieren einen speziellen Look, eine spezielle Ästhetik, die ich bestimme und die meine sehr persönliche Handschrift trägt.

Sechs bis sieben Elemente dieser elfteiligen Promptanweisung beziehen sich auf mein fotografisches, technisches, künstlerisches Fachwissen oder auf den Bildaufbau. Das ist dann quasi „wissendes Material“.

Adobe Firefly etwa geht genau den umgekehrten Weg und macht es den Leuten möglichst einfach. Da klickt man dann auf Kacheln mit Bezeichnungen wie „fotografisch“, „illustrativ“ oder „cineastisch“. Im Hintergrund werden dann vordefinierte Text-Prompts ausgelöst.

Könnte ich eigene KI-generierte Bilder vermarkten, solange das Copyright der dafür genutzten Daten nicht geklärt ist?

Da herrscht momentan noch Chaos. Ob das Grabbing fremder Bilder legal ist oder nicht, muss geklärt werden. Und auch das Copyright auf eigene KI generierte Bilder.

Midjourney und DALL-E sagen: Wir haben die Nutzungsrechte und der User das Copyright. Stable Diffusion sagt: Es gibt kein Copyright! Das ist alles Creative Commons 1.0. Die Anbieter weisen aber auf ihren Sites auch auf die jeweilige Copyright-Situation in den Ländern hin.

Was aber passiert, wenn man seine erzeugten Bilder wieder auf anderen Plattformen eingibt und dazwischen mit Photoshop bearbeitet? Das ist noch weitgehend ungeklärt. Meine Kollegin Sabine Pallaske beschäftigt sich mit solchen rechtlichen Fragen und hat die Einschätzung, dass die Regelung solcher Fragen noch bis zu zehn Jahre dauern wird.

Welches kurze Fazit des aktuellen Verhältnisses von Fotografie und KI würden Sie ziehen?

Man kann sagen, dass sich gerade das Fotografische als Bildsprache vom technischen Medium der Fotografie befreit und jetzt auch synthetisch hergestellt werden kann.

Das Gespräch führte Gunter Becker.

Titelillustration: Esther Schaarhüls

Das Magazin Fachjournalist ist eine Publikation des Deutschen Fachjournalisten-Verbands (DFJV)

© Boris Eldagsen

Der Berliner Fotokünstler Boris Eldagsen, geboren 1970 in Pirmasens, hat Philosophie und Kunst in Köln, Mainz, Prag und Hyderabad studiert. Für die DFA, die Deutsche Fotografische Akademie, moderiert er den Digitalen Dialog. Seit 2004 unterrichtet er u.a. an der Akademie für Bildende Kunst, Mainz und beim PhotoWerkBerlin. Ein weltweites Medienecho löste er durch seine öffentliche Ablehnung des SONY World Photography Award aus, den er im April mit einer KI-generierten Arbeit gewonnen hatte.